11月19日下午14:00至15:30,电院举办了一场主题为“探索数据合成与无监督学习的创新路径”的网络研讨会。此次讲座由享誉国际的Hamido Fujita教授主讲,重点介绍了深度生成建模(DGM)的最新进展,并探讨了其在数据合成和无监督学习等领域的创新应用。教授详细阐述了深度生成建模如何在多个任务中展现出强大的潜力,尤其是在处理复杂数据和提升模型鲁棒性方面的贡献。

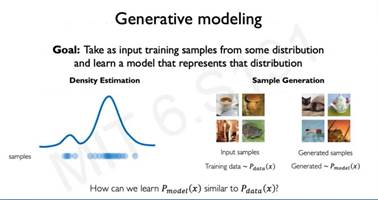

深度生成建模在多个领域取得了显著进展,但对于许多传统方法而言,尤其是在数据合成和无监督学习中,捕捉复杂数据结构和建模多样化的模式依然是一个难题。在本次讲座中,Hamido Fujita教授介绍了深度生成建模(DGM),作为应对这些挑战的有力工具。DGM的核心思想是利用深度学习架构,如生成对抗网络(GAN)、变分自编码器(VAE)等,这些架构专门用于捕捉复杂数据中的隐含模式与结构,从而提升模型的生成能力与泛化能力。

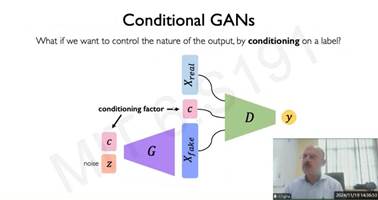

在讲座中,Hamido Fujita教授详细介绍了条件生成对抗网络(Conditional GANs)的工作原理,并解释了如何通过在生成过程中特定条件的引导,来控制输出的性质。与传统的生成对抗网络(GAN)不同,条件GAN通过引入一个额外的条件因子(C),使得生成器(G)能够根据特定的条件生成特定类型的数据。例如,在图像生成任务中,条件因子可以是标签或其他信息,这有助于生成具有特定属性的样本。教授进一步探讨了生成器如何结合噪声向量和条件因子来生成假样本(Xfake),并且判别器(D)根据真实样本(Xreal)和假样本的区分来进行训练。条件GAN的这种架构使得模型在生成数据时不仅能保留其原有的真实性,还能更好地控制输出结果,特别是在多样化任务(如图像分类、文本生成等)中的应用,展现了其在无监督学习和数据合成方面的巨大潜力。

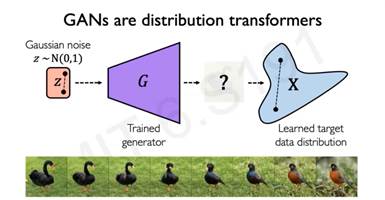

在讲座中,Hamido Fujita教授深入阐述了生成对抗网络(GANs)如何作为一种分布转换器,能够将高斯噪声转化为目标数据分布。具体来说,生成器通过从标准高斯分布中采样噪声,经过训练后,能够生成与真实数据分布相匹配的假数据。图中展示的黑天鹅和其他鸟类的图像,是通过GAN生成的,展示了生成器从随机噪声到具体数据分布的转换过程。生成对抗网络的这种能力,允许它在无监督学习中从一组噪声数据开始,通过学习目标数据的分布,最终生成与实际数据非常相似的样本。这一过程不仅能够生成静态图像,还能扩展到各种类型的数据生成任务,如图像、视频、文本等。在此过程中,生成器不断优化,力求生成的数据能够更好地“欺骗”判别器(D),使得生成数据与真实数据难以区分。这一技术在图像生成、数据增强等多个领域具有重要应用。

与会的师生通过腾讯会议参与了此次讲座,深入聆听了Hamido Fujita教授关于深度生成建模(DGM)及相关领域的独到见解。听众们积极参与讨论,围绕这些主题展开了热烈的交流,并对深度强化学习的未来发展有了更深刻的理解。本次讲座为人工智能领域的研究者们提供了一个宝贵的交流平台,促进了思想和经验的共享。